AI绘画-StableDiffusion教程之Controlnet: Controlnet Controlnet 允许通过线稿、动作识别、深度信息等对生成的图像进行控制。 请注意,在使用前请确保 ControlNet ……

哈喽!伙伴们,我是小智,你们的AI向导。欢迎来到每日的AI学习时间。今天,我们将一起深入AI的奇妙世界,探索“AI绘画-StableDiffusion教程之Controlnet”,并学会本篇文章中所讲的全部知识点。还是那句话“不必远征未知,只需唤醒你的潜能!”跟着小智的步伐,我们终将学有所成,学以致用,并发现自身的更多可能性。话不多说,现在就让我们开始这场激发潜能的AI学习之旅吧。

AI绘画-StableDiffusion教程之Controlnet:

Controlnet

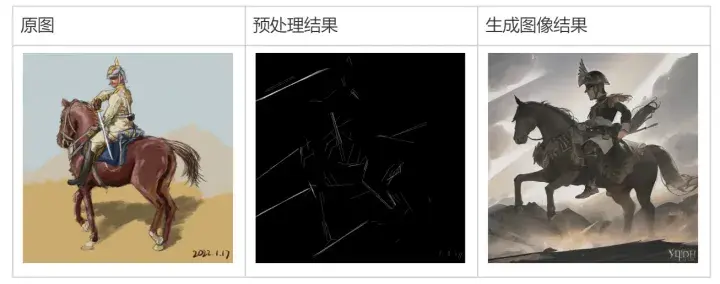

Controlnet 允许通过线稿、动作识别、深度信息等对生成的图像进行控制。

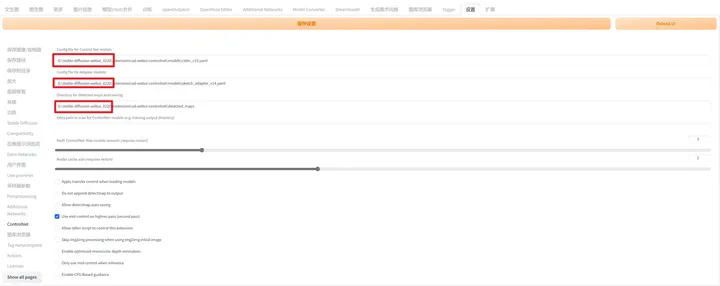

请注意,在使用前请确保 ControlNet 设置下的路径与本地 Stable Diffusion 的路径同步

基本流程

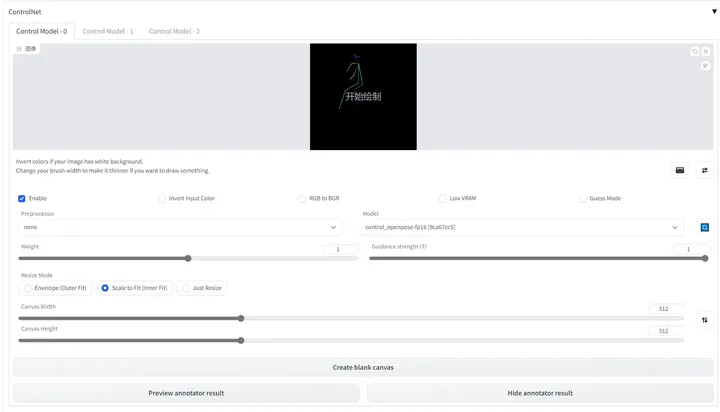

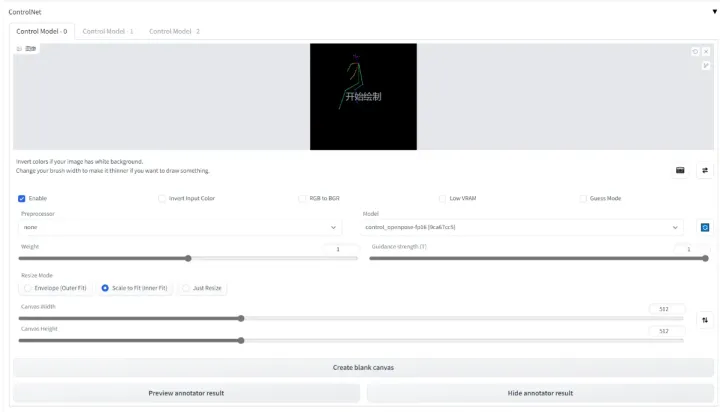

• 点击 Enable 启用该项 ControlNet

• Preprocessor 指预处理器,它将对输入的图像进行预处理。如果图像已经符合预处理后的结果,请选择 None。譬如,图中导入的图像已经是 OpenPose 需要的骨架图,那么 preprocessor 选择 none 即可。

• 在 Weight 下,可以调整该项 ControlNet 的在合成中的影响权重,与在 prompt 中调整的权重类似。Guidance strength 用来控制图像生成的前百分之多少步由 Controlnet 主导生成,这点与[:]语法类似。

• Invert Input Color 表示启动反色模式,如果输入的图片是白色背景,开启它。

• RGB to BGR 表示将输入的色彩通道信息反转,即 RGB 信息当做 BGR 信息解析,只是因为 OpenCV 中使用的是 BGR 格式。如果输入的图是法线贴图,开启它。

• Low VRAM 表示开启低显存优化,需要配合启动参数“–lowvram”。

• Guess Mode 表示无提示词模式,需要在设置中启用基于 CFG 的引导。

• Model 中请选择想要使用解析模型,应该与输入的图像或者预处理器对应。请注意,预处理器可以为空,但模型不能为空。

可用预处理/模型

canny 用于识别输入图像的边缘信息。

depth 用于识别输入图像的深度信息。

hed 用于识别输入图像的边缘信息,但边缘更柔和。

mlsd 用于识别输入图像的边缘信息,一种轻量级的边缘检测。 它对横平竖直的线条非常敏感,因此更适用于于室内图的生成。

normal 用于识别输入图像的法线信息。

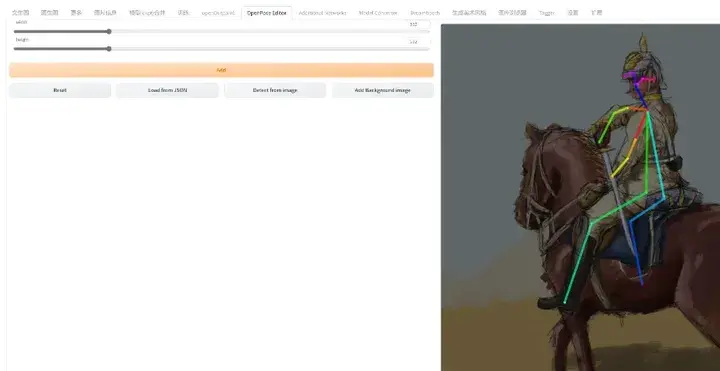

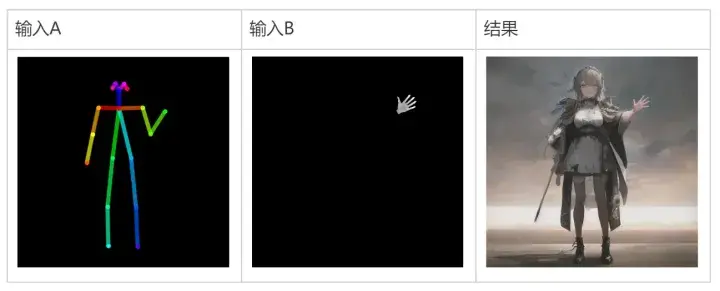

openpose 用于识别输入图像的动作信息。

OpenPose Editor 插件可以自行修改姿势,导出到文生图或图生图。

scribble 将输入图像作为线稿识别。如果线稿是白色背景,务必勾选“Invert Input Color”

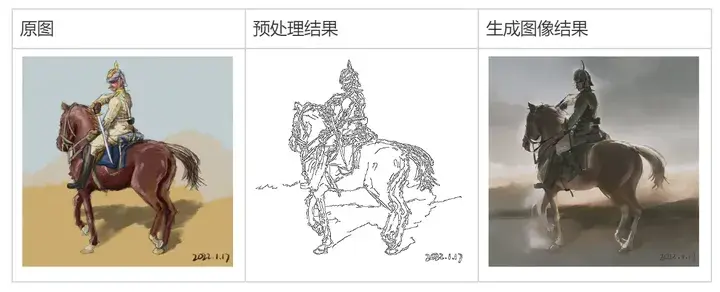

fake_scribble 识别输入图像的线稿,然后再将它作为线稿生成图像。

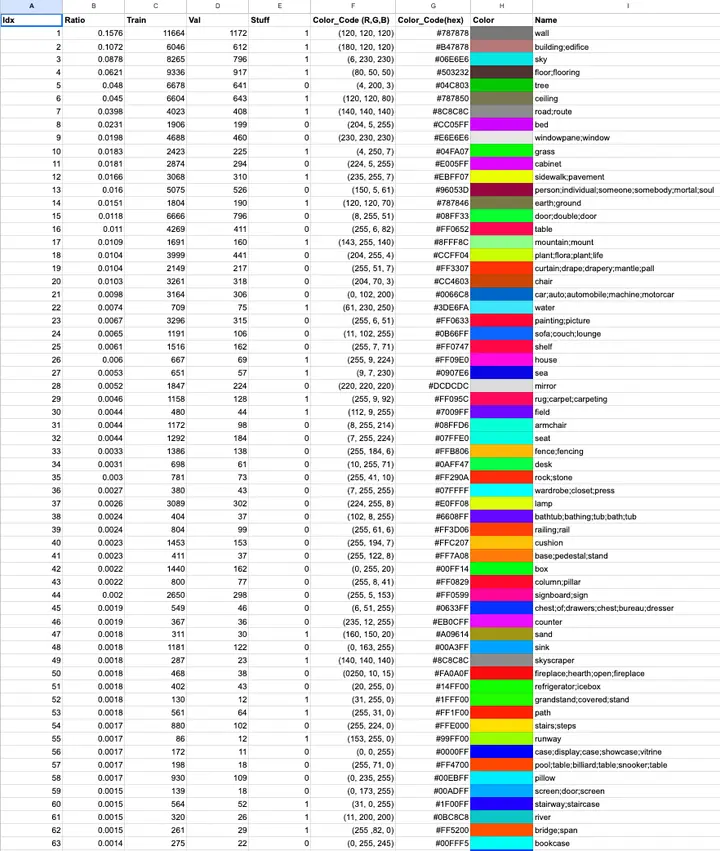

segmentation 识别输入图像各区域分别是什么类型的物品,再用此构图信息生成图像。

如果想绘制一张符合 segementation 规范的图像,可以使用以下色表绘制。

color_coding_semantic_segmentation_classes – Google 表格

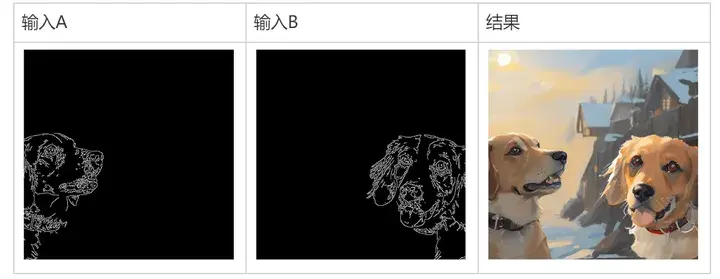

多 ControlNet 合成

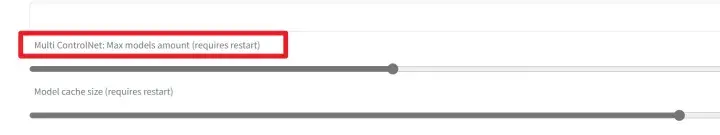

在 ControlNet 的设置下,可以调整可用 ControlNet 的数量。

在多个 ControlNet 模式下,结果会将输入的信息合并生成图像:

嘿,伙伴们,今天我们的AI探索之旅已经圆满结束。关于“AI绘画-StableDiffusion教程之Controlnet”的内容已经分享给大家了。感谢你们的陪伴,希望这次旅程让你对AI能够更了解、更喜欢。谨记,精准提问是解锁AI潜能的钥匙哦!如果有小伙伴想要了解学习更多的AI知识,请关注我们的官网“AI智研社”,保证让你收获满满呦!

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

还没有评论呢,快来抢沙发~