资源编号

15619最后更新

2025-04-27《LLMs位置编码篇》电子书下载: 这篇文章详细介绍了LLM(大型语言模型)中的位置编码及其相关技术,包括绝对位置编码、相对位置编码、Sinusoidal位置编码、旋转位置编……

哈喽!伙伴们,我是小智,你们的AI向导。欢迎来到每日的AI学习时间。今天,我们将一起深入AI的奇妙世界,探索“《LLMs位置编码篇》电子书下载”,并学会本篇文章中所讲的全部知识点。还是那句话“不必远征未知,只需唤醒你的潜能!”跟着小智的步伐,我们终将学有所成,学以致用,并发现自身的更多可能性。话不多说,现在就让我们开始这场激发潜能的AI学习之旅吧。

《LLMs位置编码篇》电子书下载:

这篇文章详细介绍了LLM(大型语言模型)中的位置编码及其相关技术,包括绝对位置编码、相对位置编码、Sinusoidal位置编码、旋转位置编码RoPE以及ALiBi(Attention with Linear Biases)等。以下是文章的主要内容:

位置编码的基本概念

1. 位置编码的定义

绝对位置编码:将位置信息直接加入到输入中,如BERT、GPT、ALBERT等模型使用。

相对位置编码:通过微调Attention结构,使其具有识别token位置信息的能力。

2. 为什么需要位置编码

注意力机制:Transformer模型中的Attention机制需要考虑输入序列中每个token与整个序列的注意力权重。

位置无关问题:未加入位置信息时,注意力权重与位置无关,不符合实际情况。

绝对位置编码

1. 训练式位置编码

定义:每个位置的位置向量会随着模型一起训练。

应用场景:应用于早期的transformer类型模型,如BERT、GPT、ALBERT等。

存在问题:模型不具有长度外推性,扩展位置编码矩阵会破坏训练阶段学习到的位置信息。

2. Sinusoidal位置编码

定义:谷歌提出的绝对位置编码,形式为正弦和余弦函数。

优点:

周期性:每个分量具有周期性。

远程衰减性:距离越远的词向量内积分数越低。

相对位置编码

1. 相对位置编码方法

XLNET式:修改Attention矩阵的二至四项,使用Sinusoidal生成式编码和可训练的向量。

T5式:删除第二、三项,添加可学习的偏置项。

DeBerta式:保留第二、三项,使用相对位置向量。

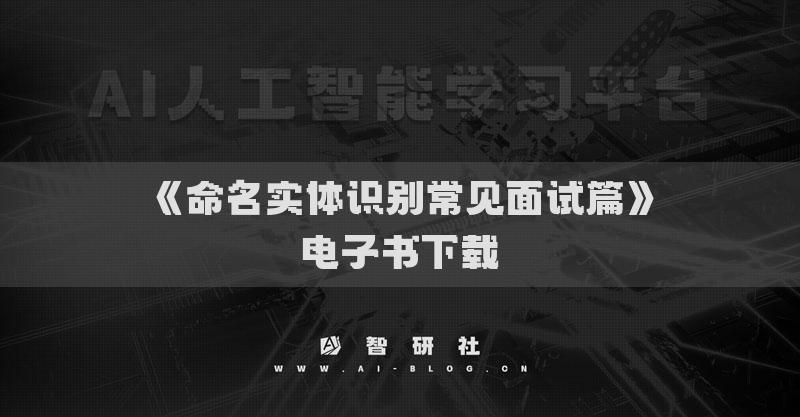

旋转位置编码RoPE

1. RoPE的基本思路

作用:作用在每个transformer层的self-attention块,计算attention score。

公式:假设存在函数g,使得

2. RoPE的优点

外推性:通过绝对位置编码实现相对位置编码,具有良好的外推性。

应用:LLaMA、GLM-130B、PaLM等大语言模型采用RoPE。

长度外推问题

1. 长度外推问题的定义

问题一:位置编码不一致,推理时有训练没见过的位置编码。

问题二:attention span大小不一致,推理时attention span更大,导致墒增。

2. 解决方法

问题一解决方法:ALIBI、KERPLE、Sandwich、xpos、PI、NTK-RoPE等。

问题二解决方法:softmax时加一个log512 n系数。

ALiBi(Attention with Linear Biases)

1. ALiBi的基本思路

计算attention score后,直接为attention score矩阵加上一个预设好的偏置矩阵。

2. ALiBi的偏置矩阵

定义:根据q和k的相对距离来惩罚attention score。

作用:相对距离越大,惩罚项越大,相当于两个token的距离越远,相互贡献越小。

3. ALiBi的优点

外推性:ALiBi位置编码具有良好的外推性。

4. ALiBi的应用

应用:BLOOM模型采用了ALiBi位置编码。

嘿,伙伴们,今天我们的AI探索之旅已经圆满结束。关于“《LLMs位置编码篇》电子书下载”的内容已经分享给大家了。感谢你们的陪伴,希望这次旅程让你对AI能够更了解、更喜欢。谨记,精准提问是解锁AI潜能的钥匙哦!如果有小伙伴想要了解学习更多的AI知识,请关注我们的官网“AI智研社”,保证让你收获满满呦!

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

还没有评论呢,快来抢沙发~