机器人学会「眼看手摸」!FreeTacMan 实现人类指尖亲自「授课」: 还记得《超凡蜘蛛侠》里加菲初获超能力时,牙膏一挤就飞,水龙头一拧就掉的桥段吗?这正是“力量失控”……

哈喽!伙伴们,我是小智,你们的AI向导。欢迎来到每日的AI学习时间。今天,我们将一起深入AI的奇妙世界,探索“机器人学会「眼看手摸」!FreeTacMan 实现人类指尖亲自「授课」”,并学会本篇文章中所讲的全部知识点。还是那句话“不必远征未知,只需唤醒你的潜能!”跟着小智的步伐,我们终将学有所成,学以致用,并发现自身的更多可能性。话不多说,现在就让我们开始这场激发潜能的AI学习之旅吧。

机器人学会「眼看手摸」!FreeTacMan 实现人类指尖亲自「授课」:

还记得《超凡蜘蛛侠》里加菲初获超能力时,牙膏一挤就飞,水龙头一拧就掉的桥段吗?这正是“力量失控”的经典瞬间 — 没有感知,更谈不上控制。相似地,机器人也常陷于同样的困境:空有一身力量却无法实现精准控制,面对柔软易碎物体时,就像刚获得超能力的普通人,捏碎塑料杯,挤飞牙膏是常有的事。

近年来,基于视觉的模仿学习在具身智能领域取得了显著进展,使机器人获得了“看见”世界的能力。但由于触觉数据的缺失,高精度接触式操作的进一步发展却十分缓慢。为什么触觉数据如此稀缺?主要原因在于数据采集效率低、采集精度有限,且难以模拟人类手指的精细触感。

为了让机器人适应自己的力量,以完成精细操作,我们亟需帮他装备触觉感知能力。最近,来自上海创智学院、香港大学、上海交通大学、复旦大学、南京大学的联合团队基于这一问题提出了全新数据采集硬件解决方案 — FreeTacMan。

FreeTacMan 是一种高效率、高精度、高数据质量的数据采集方案,借助穿戴于手指的视触觉传感器、腕部鱼眼相机以及高精度动捕设备,将人类的视觉、触觉和动作技能高效传输给机器,破解精细操作的老难题。

https://opendrivelab.com/blog/FreeTacMan

https://arxiv.org/abs/2506.01941

https://github.com/OpenDriveLab/FreeTacMan

高分辨率触觉 “皮肤”,让机器人 “看清” 触碰细节

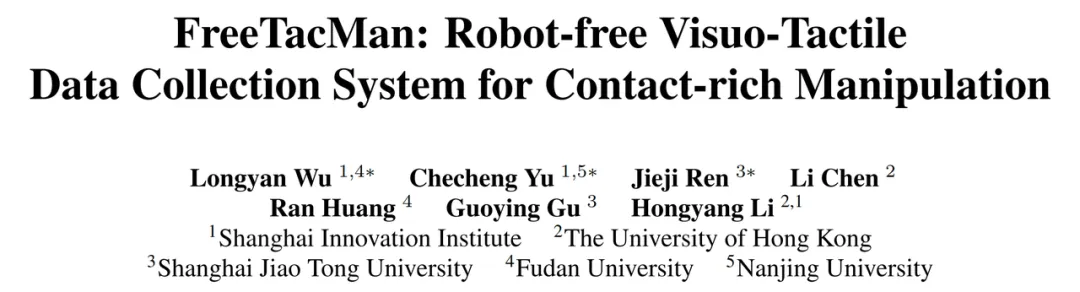

FreeTacMan 配备低成本、高分辨率视触觉传感器,厚度仅 18 毫米,却能实现 15-20 微米级空间分辨率(比传统 GelSight 传感器精度提升 50%),视野范围扩大至 358.47mm²。

具备实时触觉反馈的数采装备,让人类 “手把手” 教机器人 “感知”

相比传统手持设备需通过多级机械连杆传递触觉,FreeTacMan 将轻量高灵敏度的视触觉传感器,直接固定在操作者的指尖,传感层就像第二层皮肤 ——既贴合手指,又与被操作物体直接接触,取消多层机械连接,实现接近“零衰减”触觉反馈。这种设计不仅保留了自然的本体感觉,更让每一次动作都精准传达。为了确保这样的高保真触觉能顺畅反馈、精准控制,并适配夹爪开合所需的线性、对称运动轨迹,FreeTacMan 采用高精度线性传动结构,实现采集者低摩擦、稳态控制下的精准夹持与闭环反馈。

在机械臂的执行端,将视触觉传感器集成于夹爪,并通过定制化相机支架,确保机器人执行端的相机视角与采集端保持一致,实现视觉与触觉信息的完美对齐。更重要的是,我们的方法仅依赖于末端执行器的位姿信息,无需绑定特定机械臂型号或架构。这意味着同一套数采系统可轻松迁移至不同的机械臂平台,实现跨本体泛化能力,为多样化的机器人部署场景打开无限可能。

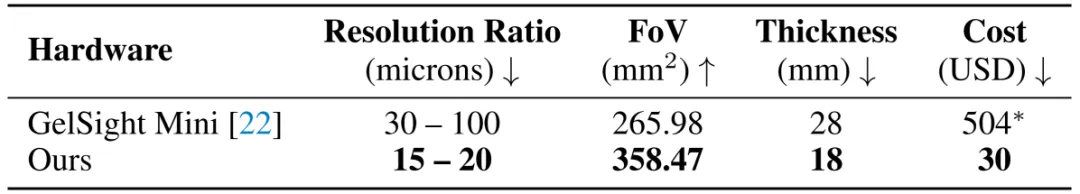

我们组织了一项包含 12 位不同经验水平的志愿者的用户研究,涵盖 8 项典型任务,对比了 FreeTacMan 与两种传统方法 — 基于主从操作的 ALOHA 和手持设备 UMI 的表现。在任务完成率、采集效率和综合评分每单位时间完成量(CPUT)三项核心指标上,FreeTacMan 全面领先。

融合时间感知的触觉预训练,让机器人从 “笨拙” 到 “灵巧”

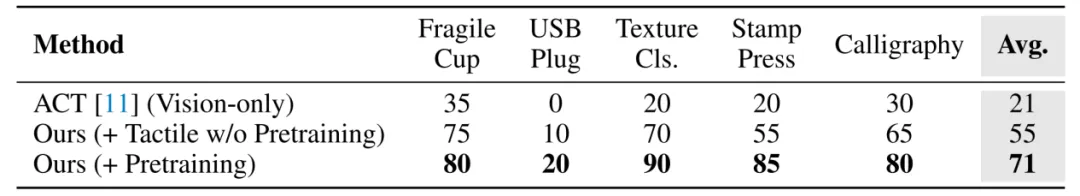

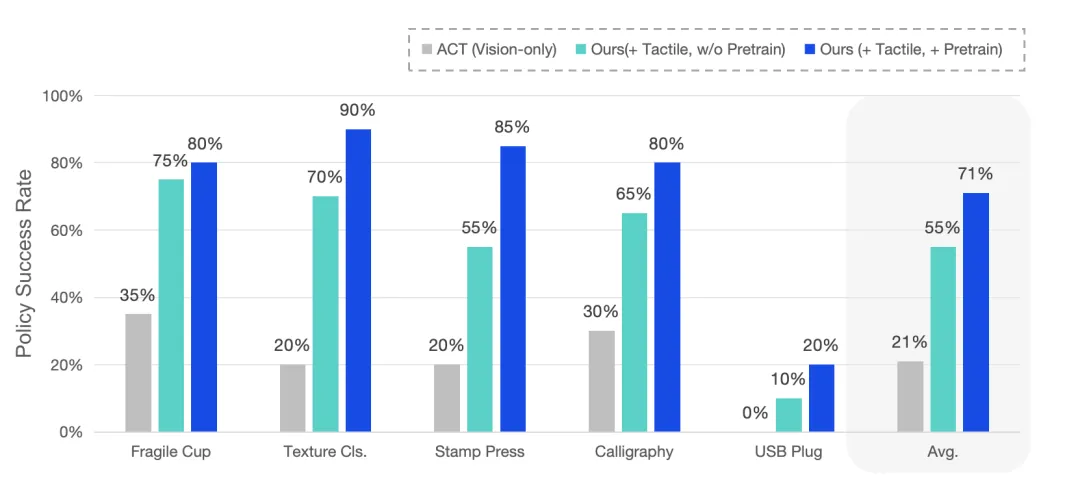

引入触觉感知后,机器人策略性能大幅提升:相比仅使用视觉的基线模型(平均成功率仅 21%),加入触觉后多任务平均成功率跃升至 55%,在易碎杯抓取和纹理分类等任务中表现尤为显著。进一步通过融合时间感知的触觉预训练,平均成功率提升至 71%,在按压印章、书法书写等精细任务中展现出对接触动态的出色掌控,充分体现了触觉在复杂操控中的核心价值。

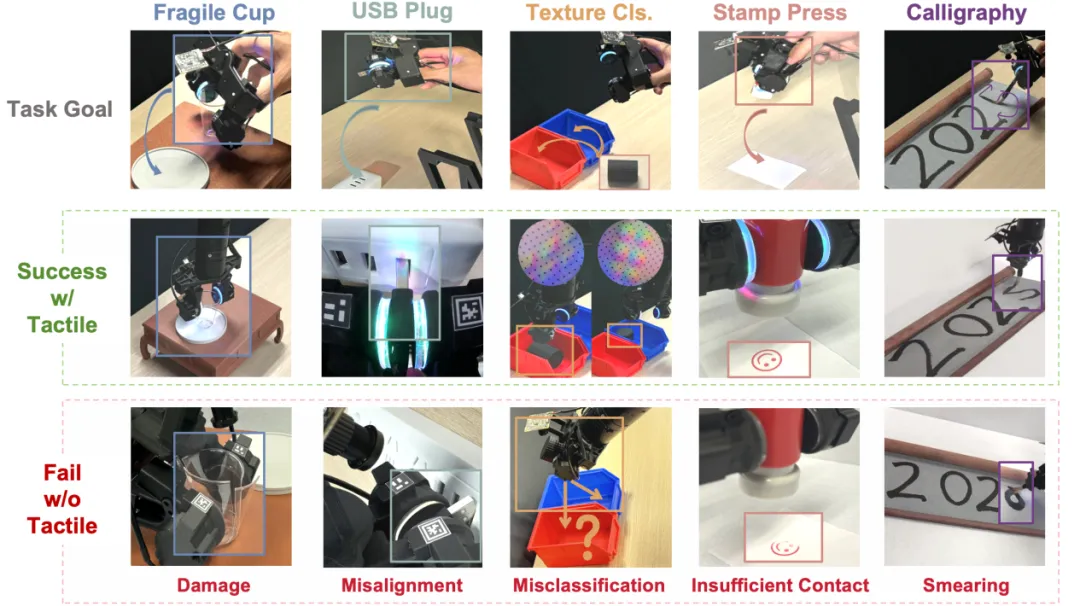

团队通过 5 项接触丰富的操作任务验证了 FreeTacMan 的性能,包括易碎杯抓放、USB 插入、纹理分类、印章按压、书法等,覆盖了力控制、滑动检测、物体姿态识别等挑战。下图直观展示了有无触觉的案例对比,触觉感知给机器人的精细操作带来了“质”的飞跃:当缺乏触觉信号时,机器人常因无法感知细微接触变化而导致任务失败(如物体滑落、被抓物体损坏或操作错位);而 FreeTacMan 通过给机器人提供实时触觉反馈,能够完成各类精细操作。

嘿,伙伴们,今天我们的AI探索之旅已经圆满结束。关于“机器人学会「眼看手摸」!FreeTacMan 实现人类指尖亲自「授课」”的内容已经分享给大家了。感谢你们的陪伴,希望这次旅程让你对AI能够更了解、更喜欢。谨记,精准提问是解锁AI潜能的钥匙哦!如果有小伙伴想要了解学习更多的AI知识,请关注我们的官网“AI智研社”,保证让你收获满满呦!

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

还没有评论呢,快来抢沙发~